Чем Q-обучение отличается от итеративной оценки в обучении с подкреплением?

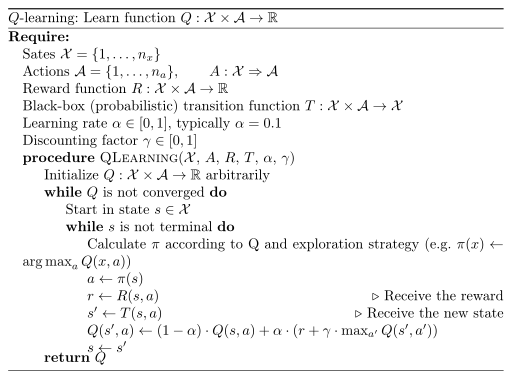

Я знаю, что Q-learning не содержит моделей, а обучающие образцы - это переходы (s, a, s', r). Но так как мы знаем переходы и вознаграждение за каждый переход в Q-Learning, разве это не то же самое, что обучение на основе моделей, где мы знаем вознаграждение за пару состояний и действий и переходы для каждого действия из состояния (быть это стохастик или детерминист)? Я не понимаю разницу.